Atualmente a proliferação de informações falsas tem sido uma preocupação crescente, e por isso as empresas de tecnologia estão aumentando seus esforços para ajudar os usuários a entender melhor o que é real e o que é falso.

Em meio a essa batalha contra a desinformação, a OpenAI anunciou recentemente uma iniciativa para fortalecer a autenticidade das imagens geradas por inteligência artificial (IA), principalmente dos seus programas ChatGPT e DALL-E.

Leia também:

The New York Times processa Microsoft e OpenAI

Nova IA “super avançada” da OpenAI não deve ser tão avançada assim, dizem especialistas

Como funcionarão a marca d’água e os metadados de procedência nas imagens

Diante das preocupações globais sobre fraudes e manipulação de imagens, que vêm se tornando cada vez mais frequentes infelizmente, a OpenAI revelou sua estratégia de 2024 para combater a disseminação de conteúdo enganoso.

Até o momento o principal ponto dessa estratégia é a inclusão de marca d’água e de metadados de procedência em imagens geradas pelo ChatGPT na web e pela API DALL-E 3, com uma atualização planejada para as versões móveis até 12 de fevereiro.

Esses metadados seguem o padrão aberto estabelecido pela Coalizão para Procedência e Autenticidade de Conteúdo (C2PA), permitindo que os usuários possam rastrear a origem e a história de uma imagem gerada por IA.

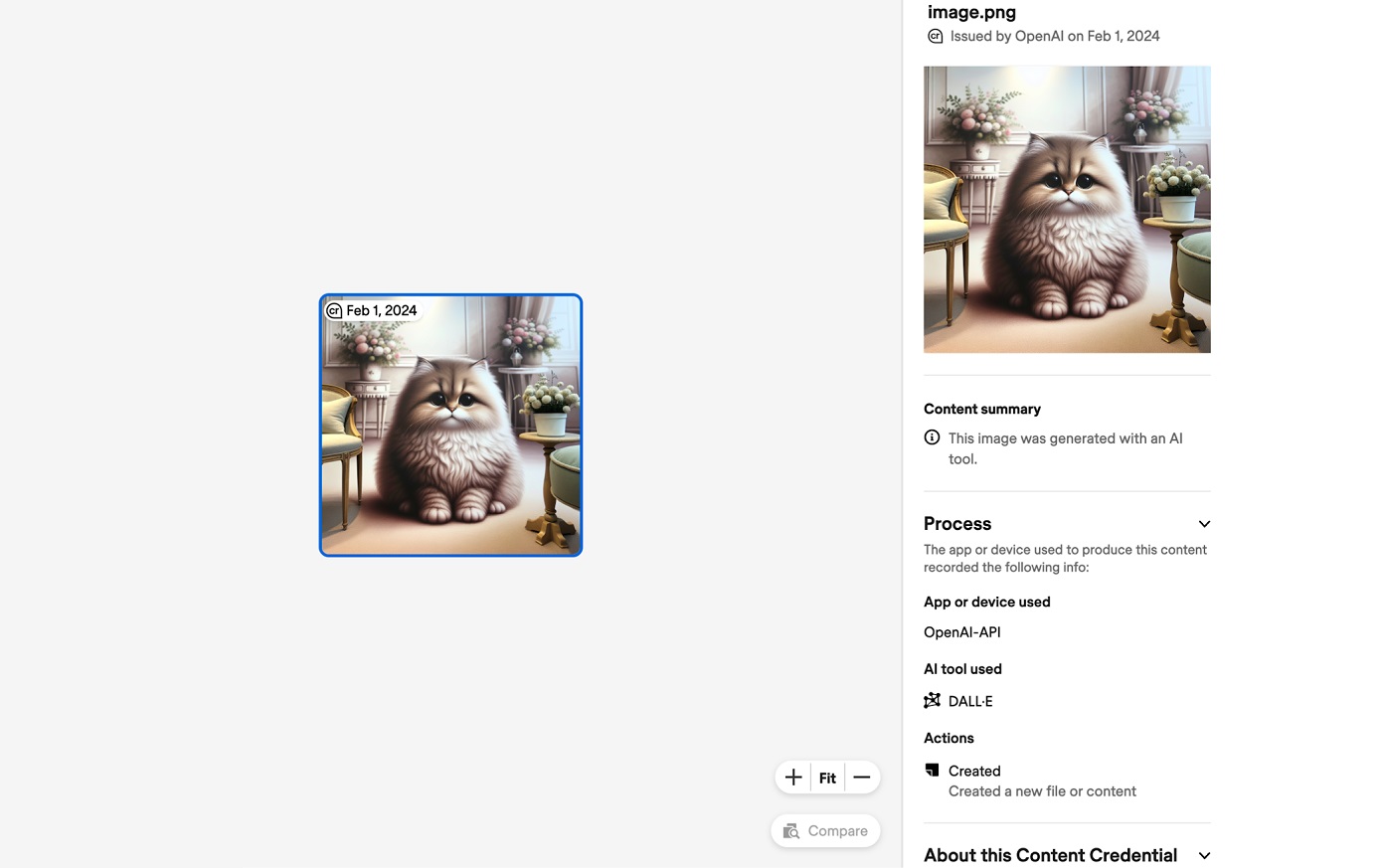

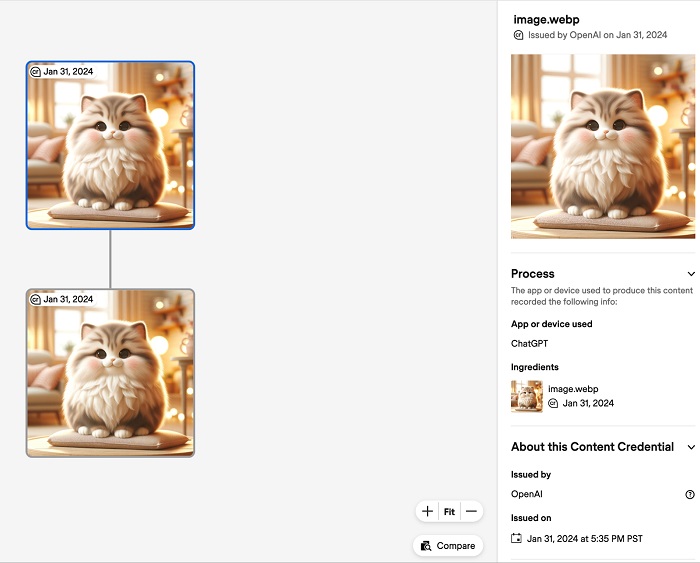

Por exemplo, uma imagem criada usando o ChatGPT exibirá um manifesto inicial de metadados indicando sua origem na API DALL-E 3, seguido por um segundo manifesto mostrando que foi gerada no ChatGPT.

Essas marcas incluirão tanto um componente de metadados invisíveis quanto um símbolo CR visível, posicionado no canto superior esquerdo de cada imagem.

Um dos principais benefícios dessas marcas d’água é a capacidade de verificar a procedência de uma imagem, ou seja, qual ferramenta de IA foi utilizada para criar o conteúdo. Isso pode ser feito através de ferramentas online como o Content Credentials Verify. No entanto, é importante notar que, até o momento, apenas imagens estáticas podem carregar a marca d’água, excluindo vídeos e textos.

OpenAI reconhece que não é um método 100% eficaz

No entanto, embora essa abordagem prometa uma nova camada de transparência e confiabilidade, ela não está isenta de desafios. A eficácia desse método de verificação depende da presença e integridade dos metadados. Sem eles, a ferramenta de verificação não pode comprovar a autenticidade de uma imagem.

Isso significa que capturas de tela e imagens compartilhadas em redes sociais, que frequentemente perdem os metadados durante o processo de compartilhamento, continuam sendo um ponto fraco na luta contra a desinformação. Isso pode acontecer tanto acidentalmente quanto propositalmente, inclusive cortando a marca d’água visível.

A OpenAI reconhece que essa não é uma solução definitiva para o problema da desinformação, mas revela acreditar que incentivar os usuários a procurar por sinais de autenticidade é um passo na direção certa.

Inclusive, em sua página de perguntas frequentes, a empresa ressalta a importância de uma abordagem proativa por parte dos usuários na verificação da credibilidade do conteúdo que consomem.

Desinformação é uma preocupação crescente

Como esse tipo de preocupação é frequente, a OpenAI não é a única empresa que estão procurando formas de inovar nessa luta contra conteúdo falso em imagens estáticas, incluindo outras gigantes da tecnologia.

Um exemplo disso é o Google DeepMind, que desenvolveu o SynthID, uma tecnologia de marca d’água digital que pode ser aplicada tanto em imagens quanto em áudio gerado por IA. Enquanto isso, a Meta está explorando a marcação invisível de água em imagens geradas por IA, uma abordagem que pode ser menos suscetível a adulterações.

Outras empresas como Adobe e Microsoft, membros da C2PA, também estão promovendo o uso de marcas d’água para identificar a procedência do conteúdo e distinguir entre conteúdo gerado por humanos e por IA.

A tecnologia tem um papel fundamental no compartilhamento de notícias e fatos, e por isso ela passa a ser não apenas ferramenta, mas também alvo de proteção contra desinformação, tendo assim um papel crucial na proteção da integridade e autenticidade do conteúdo online.

Essa nova iniciativa de introdução de metadados de procedência em imagens geradas por IA é um passo interessante nesse combate, mas mostra que é apenas um começo já que não parece ser a decisão definitiva. Algo assim provavelmente só vai acontecer diante de uma colaboração contínua entre empresas de tecnologia, reguladores e sociedade civil.

Deixe seu comentário