Durante os anos 80, ter um computador não era algo para qualquer um. Levando em conta que estamos falando do Brasil, enquanto vivíamos os anos de chumbo da reserva de mercado o Brasil estava pelo menos 10 anos defasado tecnologicamente em relação ao primeiro mundo.

Em 1981 foi lançado o IBM PC, que nos EUA já custava uma pequena fortuna

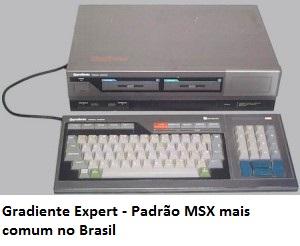

(US$ 1.565 em valores da época) no Brasil então quase impensável. No entanto no mercado existiam outros modelos de computadores pessoais, como TK-85, MSX (padrão de computador fabricado por várias empresas), Atari 400 e o CP-500 (a partir de 82) da Prológica (o que era mais usado de forma profissional) e outros aparelhos baseados no processador Z80 que inundavam o mercado, apesar de não serem baratos eram o que se conhecia por computador durante os anos 80.

Com exceção das universidades e grandes empresas, esses computadores eram na maioria das vezes usados como videogames de luxo. Pois os aplicativos mais comuns para esses aparelhos eram jogos. Alguns se aventuravam em programar em Basic porque diferente de hoje, esses computadores não traziam um sistema operacional e sim um interpretador Basic gravados em uma rom, todos os programas deveriam ou ser programados ou carregados para a memória do computador com a ajuda de gravadores cassete e só então executados. (As primeiras versões do IBM PC também eram assim, mas os modelos que mais se popularizaram no Brasil já eram versão XT, que utilizava o MS-DOS como sistema operacional.)

Manutenção

Deixando de lado o uso e levando em consideração a manutenção destes equipamentos, tínhamos basicamente uma placa de circuito impresso com os componentes soldados, uma fonte, e os dispositivos de entrada e saída conectados as portas do computador. Quando ocorriam problemas era necessária uma análise do aparelho, que de acordo com o sintoma levava o técnico ao causador da pane. Problemas como capacitores danificados, diodos e transistores abertos ou em curto, ou ainda mais complexo como circuitos integrados com defeito faziam com que esta análise fosse demorada e a manutenção relativamente cara.

O técnico precisava entender do funcionamento de instrumentos como multímetro e osciloscópio para testar cada um dos componentes que julgasse defeituoso.

O defeito considerado mais simples era com a fonte, quando interna na maioria dos equipamentos ela era linear, possuía um transformador grande e pesado que poderia ser substituído assim como seus componentes (da fonte) como ponte retificadora e capacitores de filtragem e fusível. Em outros modelos a fonte era externa bastando à compra de outra para a substituição. Mas isso se dava nos modelos que utilizavam processador Z80, nos compatíveis com o IBM PC já utilizavam fontes chaveadas, mas eram grandes e de difícil manutenção, mas como o custo de substituição era alto, era melhor o reparo. O monitor em muitos modelos era integrado ao gabinete, ou seja, quando apresentava problemas era necessário desmontar tudo e encontrar o defeito, somente técnicos em eletrônica eram aptos a estes tipos de manutenção, curiosos corriam grandes riscos visto que no caso dos monitores integrados, uma descarga elétrica poderia a chegar a alguns kV, e mesmo as fontes poderiam representar riscos por conta de capacitores carregados.

Nos modelos compatíveis com o IBM-PC, existiam algumas configurações que deveriam ser feitas no BIOS do equipamento, que diferente dos modelos compatíveis com o processador Z80 que ao serem ligados subiam o interpretador Basic e paravam ali, os compatíveis IBM possuíam um BIOS, que necessitava ser configurado, de acordo com o uso e com os dispositivos conectados à máquina. O IBM PC (XT e AT) realizava o POST e após procurava o dispositivo para o boot (assim como é até hoje), que poderia ser um disquete ou disco rígido. Quando essa configuração era perdida, utilizar a opção de restaurar as opções padrão na maioria das vezes não fazia o computador iniciar novamente. O disco rígido que àquela época ainda era padrão st-506 e unidades de disquete precisavam ser configuradas de acordo sua especificação. Não existia configuração automática.

As memórias quando não eram soldadas diretamente à placa eram encaixadas em pequenos soquetes padrão dip. Somente o acréscimo de novos chips na maioria das vezes não fazia com que essa memória fosse reconhecida, era necessário configurações na placa e no BIOS para que a nova memória fosse utilizada.

Além destas características ainda ocorria o fato de não existir um padrão definido para a maioria dos microcomputadores, no caso dos baseados em processadores z-80 cada um tinha um projeto e no caso dos compatíveis com o IBM-PC, nas versões XT, AT e 286, apesar de seguirem o padrão de compatibilidade do IBM, cada fabricante produzia com detalhes diferentes do outro na placa mãe, o que tornava a manutenção sem o manual de instruções um processo complicado.

Ainda existiam o Apple II e o Lisa, mas aqui no Brasil foram tão raros que ficam só para constar mesmo.

Durante a década de 80, a manutenção de computadores não exigia só conhecer o funcionamento do computador, mas também a eletrônica envolvida no projeto. O profissional deveria ser uma mescla entre técnico em eletrônica e em informática. Eram profissionais raros e caros, muitas vezes com formação em engenharia elétrica ou eletrônica, ou formação técnica altamente especializada. Aprender na “raça” na década de 80 era quase impossível, ainda não existia o Google. O mais próximo disso eram revistas especializadas vendidas nas bancas de jornal do tipo faça você mesmo. Mas a probabilidade ser um técnico somente lendo estas revistas era pequena.

Deixe seu comentário